Lời mở đầu

Khi mới bắt đầu ad ad đạt gặp các thuật ngữ Epoch – Batch size và Iterations trong lĩnh vực ML/DL. Và ad đặt thấy chúng khá giống nhau, nhưng thực tế là chúng khác nhau.

Để hiểu rõ sự khác biệt giữa chúng, các bạn cần tìm hiểu một số khái niệm trong machine learning như Gradient Descent.

Định nghĩa ngắn gọn của Gradient Descent: Gradient Descent là thuật toán tối ưu được sử dụng trong machine learning để tìm kết quả tốt nhất (điểm tối ưu) trên một đường cong.

Trong đó:

- Gradient có nghĩa là tỷ lệ của độ nghiêm của đường dốc.

- Descent là từ viết tắt của “decending” – nghĩa là giảm.

Thuật toán gradient Descent sẽ lặp đi lặp lại nhiều lần để tìm ra được kết quả tối ưu.

Thuật toán gradient Descent có một tham số là learning rate. Như hình phía trên bên trái, ban đầu bước nhảy khá lớn, nghĩa là giá trị learning rate lớn, và sau một vài lần lặp, điểm chấm đen đi xuống dần, và giá trị learning rate nhỏ dần theo.

Chúng ta sử dụng thuật ngữ epochs, batch size, iterations khi dữ liệu của chúng ta quá lớn (vd 10 triệu mẫu). Lúc này các khái niệm trên mới trở nên rõ ràng, còn với trường hợp dữ liệu nhỏ thì chúng khá giống nhau.

Khái niệm Epoch

Một Epoch được tính là khi chúng ta đưa tất cả dữ liệu vào mạng neural network 1 lần.

Khi dữ liệu quá lớn, chúng ta không thể đưa hết mỗi lần tất cả tập dữ liệu vào để huấn luyện được. Buộc lòng chúng ta phải chia nhỏ tập dữ liệu ra thành các batch (size nhỏ hơn).

Tại sao phải dùng hơn 1 Epoch.

Câu trả lời ở đây là tại vì chúng ta đang dùng thuật toán tối ưu là Gradient Descent. Thuật toán này đòi hỏi chúng ta phải đem toàn bộ dữ liệu qua mạng một vài lần để tìm được kết quả tối ưu. Vì vậy, dùng 1 epoch thật sự không đủ để tìm được kết quả tốt nhất.

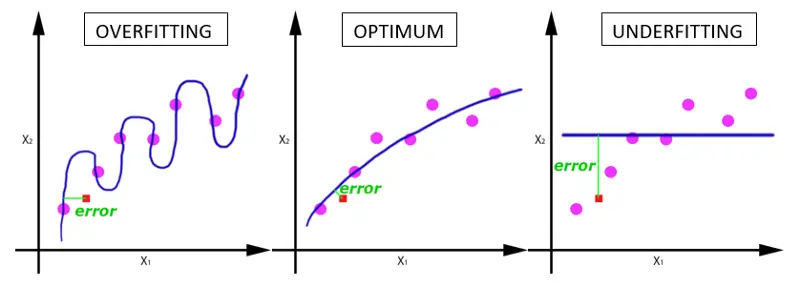

Với việc chỉ sử dụng 1 lần lặp, xác suất rất cao là dữ liệu sẽ bị underfitting (như hình mô tả bên dưới).

Khi số lần lặp tăng dần, trạng thái của mô hình sẽ chuyển dần từ underfitting sang optimal và sau đó là overfitting (thông thường là vậy, trừ khi mô hình huấn luyện của bạn đang sử dụng quá đơn giản, quá ít trọng số thì chúng không thể nào overfitting nổi).

Chúng ta có thể dùng 1 epoch để huấn luyện mô hình, với điều kiện là ta sử dụng thuật toán tối ưu không phải là gradient descent.

Số lần lặp tối ưu là bao nhiêu?

Tiếc rằng không có câu trả lời cho câu hỏi này. Phụ thuộc hoàn toàn vào tập dữ liệu của bạn đang có.

Batch Size

Batch size là số lượng mẫu dữ liệu trong một batch.

Ở đây, khái niệm batch size và số lượng batch (number of batch) là hoàn toàn khác nhau.

Như đã nói ở trên, chúng ta không thể đưa hết toàn bộ dữ liệu vào huấn luyện trong 1 epoch, vì vậy chúng ta cần phải chia tập dữ liệu thành các phần (number of batch), mỗi phần có kích thước là batch size.

Iterations

Iterations là số lượng batchs cần để hoàn thành 1 epoch.

Ví dụ chúng ta có tập dữ liệu có 20,000 mẫu, batch size là 500, vậy chúng ta cần 40 lần lặp (iteration) để hoàn thành 1 epoch.

Cảm ơn các bạn đã theo dõi bài viết.

HEFC đã chỉnh sửa lại đoạn văn này và bạn có thể xem thông tin chi tiết tại HEFC.